پیامدهای مدلهای زبانی بزرگ در امنیت فیزیکی

(large language models)

مقدمه

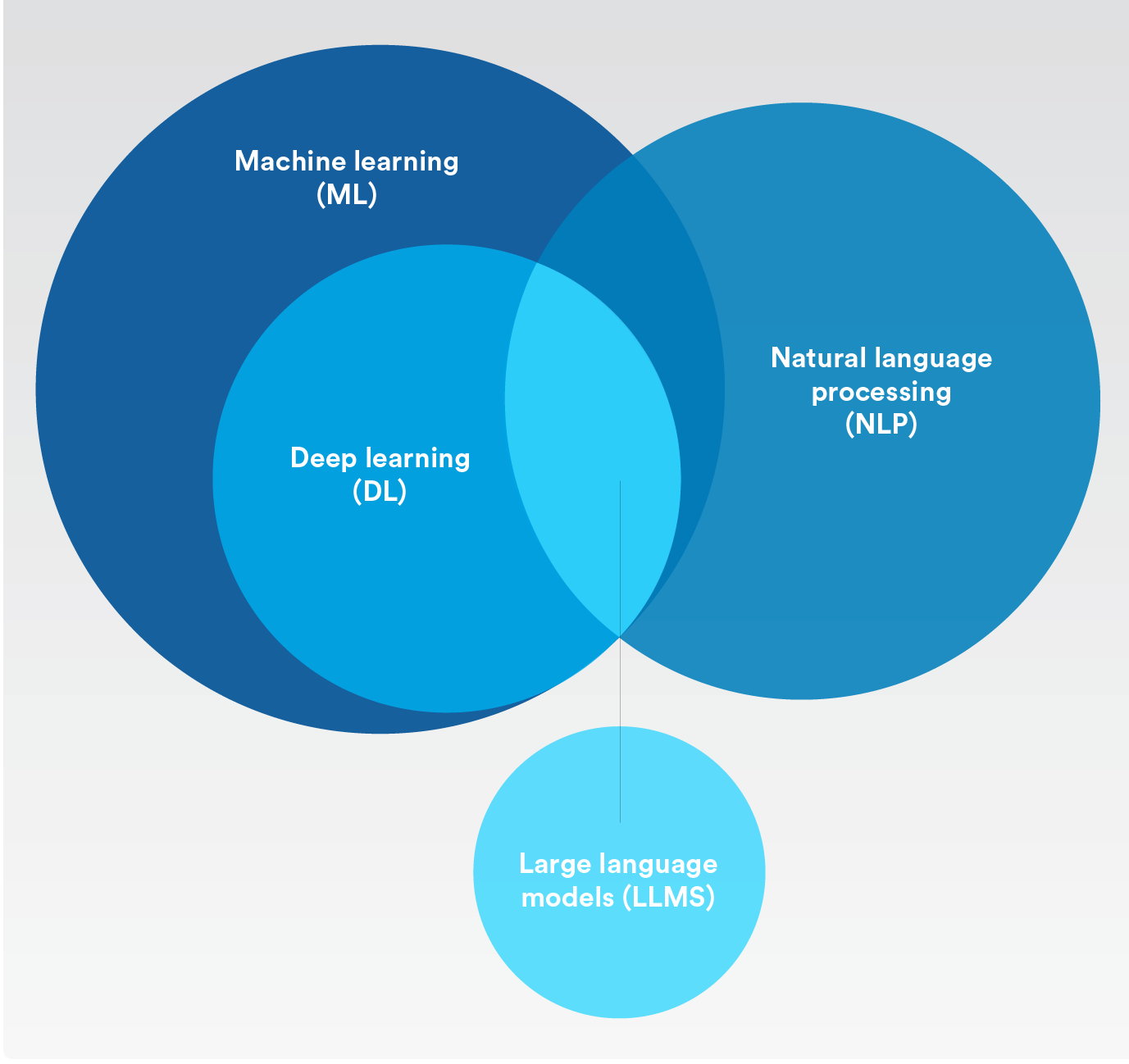

مدلهای زبانی بزرگ (LLM) مانند ChatGPT در مدت زمان کوتاهی پس از معرفی، توجه جهانی را به خود جلب کردهاند. این مدلها با توانایی درک و تولید زبان طبیعی، امکانات جدیدی را در حوزههای مختلف فراهم کردهاند. در صنعت امنیت فیزیکی، این فناوریها میتوانند به بهبود بهرهوری، امنیت و ایمنی کمک کنند. اما در کنار فرصتها، چالشهایی نیز وجود دارد که باید مورد توجه قرار گیرند.

بهترین روشها برای بهرهبرداری از هوش مصنوعی در امنیت فیزیکی

برنامههای مبتنی بر هوش مصنوعی در حال پیشرفتهای هیجانانگیزی هستند. آنها نویدبخش کمک به سازمانها در دستیابی به نتایج خاصی هستند که بهرهوری، امنیت و ایمنی را در سراسر سازمان افزایش میدهند.

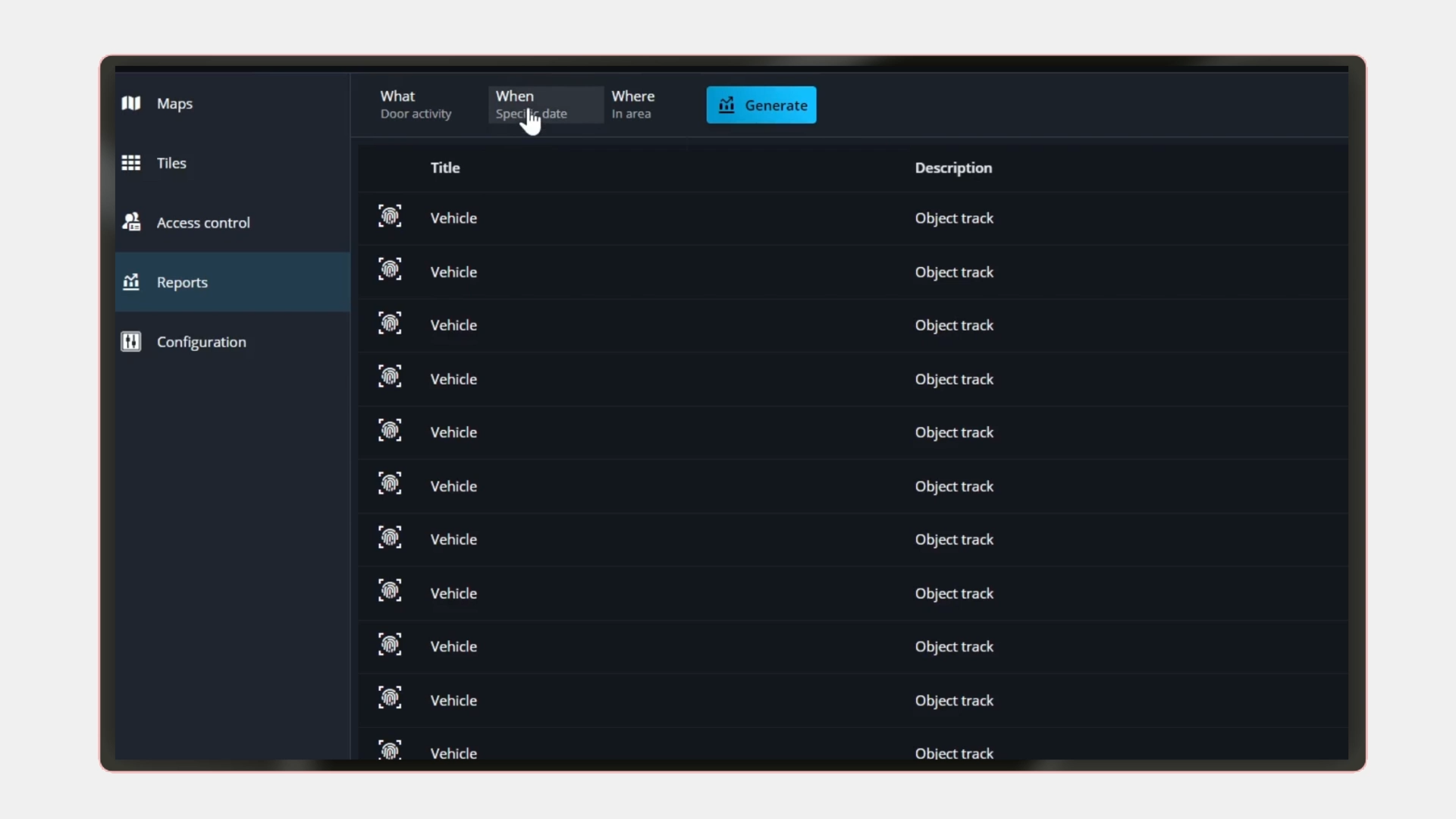

یکی از بهترین روشها برای بهرهبرداری از پیشرفتهای جدید هوش مصنوعی در امنیت فیزیکی، پیادهسازی یک پلتفرم امنیتی باز است. معماری باز به متخصصان امنیتی آزادی میدهد تا برنامههای هوش مصنوعی را که ارزش بیشتری را در عملیات آنها ایجاد میکنند، بررسی کنند. با ورود راهحلهای هوش مصنوعی به بازار، رهبران میتوانند این برنامهها را امتحان کرده و آنهایی را که بهترین تطابق را با اهداف و محیط آنها دارند، انتخاب کنند.

با ظهور فرصتهای جدید، خطرات جدیدی نیز پدیدار میشوند. به همین دلیل، همکاری با سازمانهایی که به حفاظت از دادهها، حریم خصوصی و استفاده مسئولانه از هوش مصنوعی اهمیت میدهند، اهمیت دارد. این نه تنها به تقویت مقاومت سایبری و افزایش اعتماد در سازمان شما کمک میکند، بلکه بخشی از مسئولیت اجتماعی نیز محسوب میشود.

در گزارش IBM با عنوان «اخلاق هوش مصنوعی در عمل»، ۸۵٪ از مصرفکنندگان اظهار داشتند که برای آنها مهم است که سازمانها در استفاده از هوش مصنوعی برای حل مشکلات اجتماعی، اخلاق را در نظر بگیرند. ۷۵٪ از مدیران اجرایی معتقدند که رعایت اخلاق در هوش مصنوعی میتواند شرکت را از رقبا متمایز کند. بیش از ۶۰٪ از مدیران اجرایی معتقدند که اخلاق هوش مصنوعی به سازمانهای آنها در عملکرد بهتر در زمینههای تنوع، شمول، مسئولیت اجتماعی و پایداری کمک میکند.

مطالعهای دیگر توسط Amazon Web Services (AWS) و Morning Consult نشان داد که ۷۷٪ از پاسخدهندگان اهمیت هوش مصنوعی مسئولانه را تأیید میکنند. در حالی که ۹۲٪ از کسبوکارها اعلام کردند که تا سال ۲۰۲۸ قصد دارند از راهحلهای مبتنی بر هوش مصنوعی استفاده کنند، تقریباً ۴۷٪ اظهار داشتند که در سال ۲۰۲۴ سرمایهگذاری خود را در هوش مصنوعی مسئولانه افزایش خواهند داد. بیش از یکسوم (۳۵٪) معتقدند که استفاده غیرمسئولانه از هوش مصنوعی میتواند حداقل ۱ میلیون دلار برای شرکت آنها هزینه داشته باشد یا به کسبوکار آنها آسیب برساند.

رویکرد Genetec به حریم خصوصی و حاکمیت دادهها با استفاده از هوش مصنوعی مسئولانه

از آنجا که الگوریتمهای هوش مصنوعی میتوانند حجم زیادی از دادهها را بهسرعت و با دقت پردازش کنند، هوش مصنوعی به ابزاری فزاینده مهم برای راهحلهای امنیت فیزیکی تبدیل شده است. اما با پیشرفت هوش مصنوعی، توانایی استفاده از اطلاعات شخصی به شیوههایی که ممکن است به حریم خصوصی نفوذ کند، افزایش مییابد.

مدلهای هوش مصنوعی همچنین میتوانند بهطور ناخواسته تصمیمات یا نتایج نادرستی را بر اساس سوگیریهای مختلف تولید کنند. این میتواند بر تصمیمگیریها تأثیر بگذارد و در نهایت منجر به تبعیض شود. در حالی که هوش مصنوعی قدرت تحول در نحوه انجام کارها و تصمیمگیریها را دارد، باید بهطور مسئولانه پیادهسازی شود. اعتماد برای رشد و پایداری دنیای دیجیتال ما ضروری است. و بهترین راه برای ایجاد اعتماد؟ همکاری با سازمانهایی است که به حفاظت از دادهها، حریم خصوصی و استفاده مسئولانه از هوش مصنوعی اهمیت میدهند.

به همین دلیل، تیم ما در Genetec™ هوش مصنوعی مسئولانه را جدی میگیرد. در واقع، ما مجموعهای از اصول راهنما برای ایجاد، بهبود و نگهداری مدلهای هوش مصنوعی خود تدوین کردهایم. این اصول شامل سه ستون اصلی زیر است:

حریم خصوصی و حاکمیت دادهها

بهعنوان یک ارائهدهنده فناوری، ما مسئولیت استفاده از هوش مصنوعی در توسعه راهحلهای خود را بر عهده میگیریم. این بدان معناست که ما فقط از مجموعهدادههایی استفاده میکنیم که با مقررات حفاظت از دادههای مربوطه مطابقت دارند. و هر جا که ممکن باشد، مجموعهدادهها را ناشناسسازی میکنیم و دادههای مورد استفاده برای آموزش مدلهای یادگیری ماشین را بهطور اخلاقی تهیه و بهصورت ایمن ذخیره میکنیم. ما همچنین مجموعهدادهها را با نهایت دقت پردازش میکنیم و حفاظت از دادهها و حریم خصوصی را در همه کارهایی که انجام میدهیم، در نظر میگیریم. این شامل پایبندی به اقدامات سختگیرانه مجوزدهی و احراز هویت است تا اطمینان حاصل شود که افراد نادرست به دادهها و اطلاعات حساس در برنامههای مبتنی بر هوش مصنوعی ما دسترسی پیدا نمیکنند. ما متعهد به ارائه ابزارهای داخلی به مشتریان خود هستیم که به آنها در رعایت مقررات در حال تحول هوش مصنوعی کمک میکند.

قابلیت اعتماد و ایمنی

قابلیت اعتماد و ایمنی

در هنگام توسعه و استفاده از مدلهای هوش مصنوعی، ما همیشه به این فکر میکنیم که چگونه میتوانیم سوگیری را به حداقل برسانیم. هدف ما این است که اطمینان حاصل کنیم راهحلهای ما همیشه نتایجی متعادل و عادلانه ارائه میدهند. بخشی از این اطمینان شامل آزمایش دقیق مدلهای هوش مصنوعی ما قبل از به اشتراکگذاری آنها با مشتریان است. ما همچنین سخت تلاش میکنیم تا دقت و اعتماد به مدلهای خود را بهطور مداوم بهبود بخشیم. در نهایت، ما تلاش میکنیم تا مدلهای هوش مصنوعی خود را قابل توضیح کنیم. این بدان معناست که وقتی الگوریتمهای هوش مصنوعی ما تصمیمی میگیرند یا نتیجهای ارائه میدهند، ما قادر خواهیم بود دقیقاً به مشتریان خود بگوییم که چگونه به آن نتیجه رسیدهایم.

حضور انسان در فرآیند تصمیمگیری

در Genetec، ما اطمینان حاصل میکنیم که مدلهای هوش مصنوعی ما نمیتوانند بهتنهایی تصمیمات حیاتی بگیرند. ما معتقدیم که همیشه باید یک انسان در فرآیند تصمیمگیری حضور داشته باشد و نظر نهایی را بدهد. زیرا در زمینه امنیت فیزیکی، اولویت دادن به تصمیمگیری انسانی حیاتی است. در موقعیتهای مرگ و زندگی، انسانها بهطور ذاتی خطرات موجود و اقدامات لازم برای نجات جان را درک میکنند. ماشینها بهسادگی نمیتوانند پیچیدگیهای رویدادهای واقعی را مانند یک اپراتور امنیتی درک کنند، بنابراین تکیه صرف بر مدلهای آماری نمیتواند پاسخگو باشد. به همین دلیل است که ما همیشه هدفمان توانمندسازی افراد از طریق افزایش ظرفیت آنها است. این بدان معناست که سیستمهای ما باید همیشه بینشهایی را ارائه دهند که ظرفیت قضاوت انسانی را افزایش دهند.

نتیجهگیری

نتیجهگیری

مدلهای زبانی بزرگ (LLM) پتانسیل بالایی برای تحول در صنعت امنیت فیزیکی دارند. اما استفاده از آنها باید با دقت و مسئولیتپذیری همراه باشد. با رعایت اصول حریم خصوصی، قابلیت اعتماد و حضور انسان در تصمیمگیری، میتوان از مزایای این فناوری بهرهمند شد و در عین حال خطرات آن را کاهش داد.

Recent Posts

- ویدئو شفافتر، تحلیل دقیقتر: AV1 چطور آنالیتیکس ابری را متحول میکند؟

- تعمیرات تخصصی دوربینهای AXIS – راهکاری مطمئن برای افزایش عمر مفید و بازگردانی عملکرد حرفهای سیستمهای نظارت تصویری

- نوآوری در رادار: تحول در حوزه نظارت تصویری و امنیت

- آزادسازی بهرهوری عملیاتی و هوش تجاری با راهکار نظارت و امنیتی

- چهارشنبههای آموزشی پیشتازان ارتباط مجازی

Search

Recent Comments

Archives

- دسامبر 2025

- نوامبر 2025

- اکتبر 2025

- سپتامبر 2025

- آگوست 2025

- جولای 2025

- ژوئن 2025

- می 2025

- آوریل 2025

- نوامبر 2024

- اکتبر 2024

- سپتامبر 2024

- ژانویه 2024

- نوامبر 2023

- سپتامبر 2023

- آگوست 2023

- جولای 2023

- ژوئن 2023

- می 2023

- آوریل 2023

- ژانویه 2023

- دسامبر 2022

- نوامبر 2022

- اکتبر 2022

- سپتامبر 2022

- آگوست 2022

- می 2022

- ژانویه 2022

- دسامبر 2021

- نوامبر 2021

- اکتبر 2021

- سپتامبر 2021

- آگوست 2019

- ژانویه 2019

- اکتبر 2018